Análise de dados - Data analysis

| Parte de uma série de estatísticas |

| Visualização de dados |

|---|

| Dimensões principais |

| Figuras importantes |

| Tipos gráficos de informação |

| tópicos relacionados |

| Física computacional |

|---|

|

|

Mecânica · Eletromagnética · Termodinâmica · Simulação |

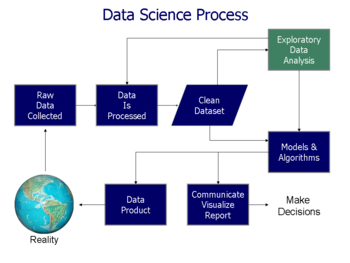

A análise de dados é um processo de inspeção, limpeza , transformação e modelagem de dados com o objetivo de descobrir informações úteis, informar conclusões e apoiar a tomada de decisões. A análise de dados tem várias facetas e abordagens, abrangendo diversas técnicas sob uma variedade de nomes e é usada em diferentes negócios, ciências e domínios das ciências sociais. No mundo dos negócios de hoje, a análise de dados desempenha um papel na tomada de decisões mais científicas e ajudando as empresas a operar com mais eficácia.

A mineração de dados é uma técnica de análise de dados específica que se concentra na modelagem estatística e na descoberta de conhecimento para fins preditivos em vez de puramente descritivos, enquanto a inteligência de negócios cobre a análise de dados que depende fortemente de agregação, com foco principalmente nas informações de negócios. Em aplicativos estatísticos, a análise de dados pode ser dividida em estatística descritiva , análise exploratória de dados (EDA) e análise de dados confirmatória (CDA). O EDA se concentra em descobrir novos recursos nos dados, enquanto o CDA se concentra em confirmar ou falsificar hipóteses existentes . A análise preditiva se concentra na aplicação de modelos estatísticos para previsão ou classificação preditiva, enquanto a análise de texto aplica técnicas estatísticas, linguísticas e estruturais para extrair e classificar informações de fontes textuais, uma espécie de dados não estruturados . Todos os itens acima são variedades de análise de dados.

A integração de dados é um precursor da análise de dados, e a análise de dados está intimamente ligada à visualização e disseminação de dados.

O processo de análise de dados

Análise , refere-se a dividir um todo em seus componentes separados para exame individual. A análise de dados , é um processo de obtenção de dados brutos , e posteriormente convertê-los em informações úteis para a tomada de decisão dos usuários. Os dados são coletados e analisados para responder a perguntas, testar hipóteses ou refutar teorias.

O estatístico John Tukey , definiu a análise de dados em 1961, como:

"Procedimentos de análise de dados, técnicas de interpretação dos resultados de tais procedimentos, formas de planejar a coleta de dados para tornar sua análise mais fácil, mais precisa ou mais exata, e todos os mecanismos e resultados das estatísticas (matemáticas) aplicáveis à análise de dados . "

Existem várias fases que podem ser distinguidas, descritas a seguir. As fases são iterativas , em que o feedback das fases posteriores pode resultar em trabalho adicional nas fases anteriores. A estrutura CRISP , usada na mineração de dados , tem etapas semelhantes.

Requisitos de dados

Os dados são necessários como entradas para a análise, que é especificada com base nos requisitos daqueles que dirigem a análise (ou clientes, que usarão o produto acabado da análise). O tipo geral de entidade sobre a qual os dados serão coletados é referido como uma unidade experimental (por exemplo, uma pessoa ou população de pessoas). Variáveis específicas relacionadas a uma população (por exemplo, idade e renda) podem ser especificadas e obtidas. Os dados podem ser numéricos ou categóricos (ou seja, um rótulo de texto para números).

Coleção de dados

Os dados são coletados de várias fontes. Os requisitos podem ser comunicados por analistas aos guardiões dos dados; como, por exemplo, pessoal de Tecnologia da Informação dentro de uma organização. Os dados também podem ser coletados de sensores no ambiente, incluindo câmeras de tráfego, satélites, dispositivos de gravação, etc. Também podem ser obtidos por meio de entrevistas, downloads de fontes online ou leitura de documentação.

Processamento de dados

Os dados, quando obtidos inicialmente, devem ser processados ou organizados para análise. Por exemplo, isso pode envolver a colocação de dados em linhas e colunas em um formato de tabela ( conhecido como dados estruturados ) para análise posterior, geralmente por meio do uso de planilhas ou software estatístico.

Limpeza de dados

Depois de processados e organizados, os dados podem estar incompletos, conter duplicatas ou conter erros. A necessidade de limpeza de dados surgirá de problemas na maneira como os dados são inseridos e armazenados. A limpeza de dados é o processo de prevenção e correção desses erros. As tarefas comuns incluem correspondência de registros, identificação de imprecisões de dados, qualidade geral dos dados existentes, desduplicação e segmentação de coluna. Esses problemas de dados também podem ser identificados por meio de uma variedade de técnicas analíticas. Por exemplo; com as informações financeiras, os totais de variáveis específicas podem ser comparados com números publicados separadamente que se acredita serem confiáveis. Valores incomuns, acima ou abaixo de limites predeterminados, também podem ser revisados. Existem vários tipos de limpeza de dados, que dependem do tipo de dados no conjunto; podem ser números de telefone, endereços de e-mail, empregadores ou outros valores. Métodos de dados quantitativos para detecção de valores discrepantes podem ser usados para eliminar dados que parecem ter uma maior probabilidade de serem inseridos incorretamente. Os verificadores ortográficos de dados textuais podem ser usados para diminuir a quantidade de palavras digitadas incorretamente. No entanto, é mais difícil dizer se as próprias palavras estão corretas.

Análise exploratória de dados

Depois que os conjuntos de dados são limpos, eles podem ser analisados. Os analistas podem aplicar uma variedade de técnicas, conhecidas como análise exploratória de dados , para começar a entender as mensagens contidas nos dados obtidos. O processo de exploração de dados pode resultar em limpeza adicional de dados ou solicitações adicionais de dados; portanto, a inicialização das fases iterativas mencionadas no parágrafo inicial desta seção. Estatísticas descritivas , como a média ou mediana, podem ser geradas para auxiliar na compreensão dos dados. A visualização de dados também é uma técnica utilizada, na qual o analista pode examinar os dados em formato gráfico para obter insights adicionais sobre as mensagens contidas nos dados.

Modelagem e algoritmos

Fórmulas ou modelos matemáticos (conhecidos como algoritmos ) podem ser aplicados aos dados para identificar relações entre as variáveis; por exemplo, usando correlação ou causalidade . Em termos gerais, os modelos podem ser desenvolvidos para avaliar uma variável específica com base em outras variáveis contidas no conjunto de dados, com algum erro residual dependendo da precisão do modelo implementado ( por exemplo , Dados = Modelo + Erro).

A estatística inferencial inclui a utilização de técnicas que medem as relações entre variáveis específicas. Por exemplo, a análise de regressão pode ser usada para modelar se uma mudança na propaganda ( variável independente X ) fornece uma explicação para a variação nas vendas ( variável dependente Y ). Em termos matemáticos, Y (vendas) é uma função de X (publicidade). Pode ser descrito como ( Y = aX + b + erro), em que o modelo é concebido de tal modo que ( a ) e ( b ) minimizar o erro quando o modelo prediz Y para um determinado intervalo de valores de X . Os analistas também podem tentar construir modelos descritivos dos dados, com o objetivo de simplificar a análise e comunicar os resultados.

Produto de dados

Um produto de dados é um aplicativo de computador que recebe entradas de dados e gera saídas , devolvendo-as ao ambiente. Pode ser baseado em um modelo ou algoritmo. Por exemplo, um aplicativo que analisa dados sobre o histórico de compras do cliente e usa os resultados para recomendar outras compras que o cliente possa desfrutar.

Comunicação

Uma vez que os dados são analisados, eles podem ser relatados em vários formatos aos usuários da análise para apoiar seus requisitos. Os usuários podem ter feedback, o que resulta em análises adicionais. Como tal, grande parte do ciclo analítico é iterativo.

Ao determinar como comunicar os resultados, o analista pode considerar a implementação de uma variedade de técnicas de visualização de dados para ajudar a comunicar a mensagem de forma mais clara e eficiente para o público. A visualização de dados usa telas de informações (gráficos como tabelas e gráficos) para ajudar a comunicar as mensagens principais contidas nos dados. As tabelas são uma ferramenta valiosa, pois permitem ao usuário consultar e focar em números específicos; enquanto gráficos (por exemplo, gráficos de barras ou gráficos de linha), podem ajudar a explicar as mensagens quantitativas contidas nos dados.

Mensagens quantitativas

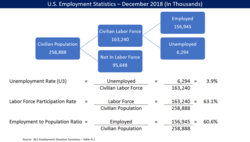

Stephen Few descreveu oito tipos de mensagens quantitativas que os usuários podem tentar entender ou comunicar a partir de um conjunto de dados e os gráficos associados usados para ajudar a comunicar a mensagem. Os clientes que especificam os requisitos e os analistas que executam a análise de dados podem considerar essas mensagens durante o curso do processo.

- Série temporal: uma única variável é capturada ao longo de um período de tempo, como a taxa de desemprego em um período de 10 anos. Um gráfico de linha pode ser usado para demonstrar a tendência.

- Classificação: subdivisões categóricas são classificadas em ordem crescente ou decrescente, como uma classificação de desempenho de vendas (a medida ) por vendedores (a categoria , com cada vendedor uma subdivisão categórica ) durante um único período. Um gráfico de barras pode ser usado para mostrar a comparação entre os vendedores.

- Parte para todo: subdivisões categóricas são medidas como uma proporção do todo (ou seja, uma porcentagem de 100%). Um gráfico de pizza ou de barras pode mostrar a comparação de proporções, como a participação de mercado representada pelos concorrentes em um mercado.

- Desvio: subdivisões categóricas são comparadas com uma referência, como uma comparação entre despesas reais e orçadas para vários departamentos de uma empresa em um determinado período. Um gráfico de barras pode mostrar a comparação entre o valor real e o de referência.

- Distribuição de frequência: mostra o número de observações de uma variável específica para um determinado intervalo, como o número de anos em que o retorno do mercado de ações está entre intervalos como 0–10%, 11–20%, etc. Um histograma , um tipo de gráfico de barras, pode ser usado para esta análise.

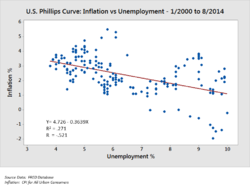

- Correlação: comparação entre observações representadas por duas variáveis (X, Y) para determinar se elas tendem a se mover na mesma direção ou em direções opostas. Por exemplo, traçando o desemprego (X) e a inflação (Y) para uma amostra de meses. Um gráfico de dispersão é normalmente usado para esta mensagem.

- Comparação nominal: comparação de subdivisões categóricas em nenhuma ordem específica, como o volume de vendas por código de produto. Um gráfico de barras pode ser usado para esta comparação.

- Geográfico ou geoespacial: comparação de uma variável em um mapa ou layout, como a taxa de desemprego por estado ou o número de pessoas nos vários andares de um edifício. Um cartograma é um gráfico típico usado.

Técnicas para analisar dados quantitativos

O autor Jonathan Koomey recomendou uma série de práticas recomendadas para a compreensão de dados quantitativos. Esses incluem:

- Verifique se há anomalias nos dados brutos antes de realizar uma análise;

- Execute novamente cálculos importantes, como verificar colunas de dados que são orientados por fórmulas;

- Confirme se os totais principais são a soma dos subtotais;

- Verifique as relações entre os números que devem ser relacionados de forma previsível, como proporções ao longo do tempo;

- Normalize números para tornar as comparações mais fáceis, como analisar valores por pessoa ou em relação ao PIB ou como um valor de índice em relação a um ano base;

- Divida os problemas em partes componentes, analisando os fatores que levaram aos resultados, como a análise de retorno sobre o patrimônio líquido da DuPont .

Para as variáveis em exame, os analistas normalmente obtêm estatísticas descritivas para elas, como a média (média), mediana e desvio padrão . Eles também podem analisar a distribuição das variáveis-chave para ver como os valores individuais se agrupam em torno da média.

Os consultores da McKinsey and Company nomearam uma técnica para decompor um problema quantitativo em suas partes componentes, chamada de princípio MECE . Cada camada pode ser dividida em seus componentes; cada um dos subcomponentes deve ser mutuamente exclusivo um do outro e, coletivamente, somar à camada acima deles. O relacionamento é conhecido como "Mutuamente Exclusivo e Coletivamente Exaustivo" ou MECE. Por exemplo, o lucro, por definição, pode ser dividido em receita total e custo total. Por sua vez, a receita total pode ser analisada por seus componentes, como a receita das divisões A, B e C (que são mutuamente exclusivas entre si) e deve somar à receita total (exaustivas coletivamente).

Os analistas podem usar medições estatísticas robustas para resolver certos problemas analíticos. O teste de hipóteses é usado quando uma hipótese particular sobre o verdadeiro estado de coisas é feita pelo analista e os dados são coletados para determinar se esse estado de coisas é verdadeiro ou falso. Por exemplo, a hipótese pode ser a de que "O desemprego não tem efeito sobre a inflação", o que se relaciona a um conceito econômico denominado Curva de Phillips . O teste de hipóteses envolve a consideração da probabilidade de erros do tipo I e do tipo II , que se relacionam ao fato de os dados apoiarem a aceitação ou rejeição da hipótese.

A análise de regressão pode ser usada quando o analista está tentando determinar até que ponto a variável independente X afeta a variável dependente Y (por exemplo, "Até que ponto as mudanças na taxa de desemprego (X) afetam a taxa de inflação (Y)?"). Esta é uma tentativa de modelar ou ajustar uma linha ou curva de equação aos dados, de forma que Y seja uma função de X.

A análise de condição necessária (NCA) pode ser usada quando o analista está tentando determinar até que ponto a variável independente X permite a variável Y (por exemplo, "Até que ponto uma determinada taxa de desemprego (X) é necessária para uma determinada taxa de inflação (Y) ? "). Enquanto a análise de regressão (múltipla) usa lógica aditiva onde cada variável X pode produzir o resultado e os Xs podem compensar um ao outro (eles são suficientes, mas não necessários), a análise de condição necessária (NCA) usa lógica de necessidade, onde um ou mais X - as variáveis permitem que o resultado exista, mas podem não produzi-lo (são necessárias, mas não suficientes). Cada condição necessária deve estar presente e a compensação não é possível.

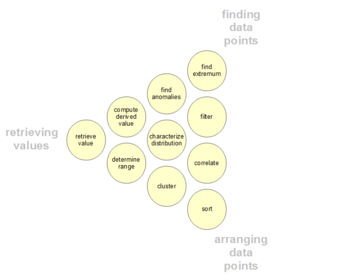

Atividades analíticas de usuários de dados

Os usuários podem ter pontos de dados específicos de interesse em um conjunto de dados, ao contrário das mensagens gerais descritas acima. Essas atividades analíticas do usuário de baixo nível são apresentadas na tabela a seguir. A taxonomia também pode ser organizada por três pólos de atividades: recuperação de valores, localização de pontos de dados e organização de pontos de dados.

| # | Tarefa | Descrição Geral |

Resumo Pro Forma |

Exemplos |

|---|---|---|---|---|

| 1 | Recuperar valor | Dado um conjunto de casos específicos, encontre os atributos desses casos. | Quais são os valores dos atributos {X, Y, Z, ...} nos casos de dados {A, B, C, ...}? |

- Qual é a quilometragem por galão do Ford Mondeo?

- Quanto tempo dura o filme E o Vento Levou? |

| 2 | Filtro | Dadas algumas condições concretas sobre valores de atributos, encontre casos de dados que satisfaçam essas condições. | Quais casos de dados satisfazem as condições {A, B, C ...}? |

- Quais cereais Kellogg's têm alto teor de fibras?

- Quais comédias ganharam prêmios? - Quais fundos tiveram desempenho inferior ao SP-500? |

| 3 | Calcular Valor Derivado | Dado um conjunto de casos de dados, calcule uma representação numérica agregada desses casos de dados. | Qual é o valor da função de agregação F sobre um determinado conjunto S de casos de dados? |

- Qual é o conteúdo calórico médio dos cereais Post?

- Qual é a receita bruta de todas as lojas combinadas? - Quantos fabricantes de automóveis existem? |

| 4 | Encontre Extremum | Encontre casos de dados que possuem um valor extremo de um atributo em seu intervalo dentro do conjunto de dados. | Quais são os N casos de dados superiores / inferiores em relação ao atributo A? |

- Qual é o carro com maior MPG?

- Qual diretor / filme ganhou mais prêmios? - Qual filme da Marvel Studios tem a data de lançamento mais recente? |

| 5 | Ordenar | Dado um conjunto de casos de dados, classifique-os de acordo com alguma métrica ordinal. | Qual é a ordem de classificação de um conjunto S de casos de dados de acordo com seu valor do atributo A? |

- Encomende os carros por peso.

- Classifique os cereais por calorias. |

| 6 | Determinar Alcance | Dado um conjunto de casos de dados e um atributo de interesse, encontre a amplitude de valores dentro do conjunto. | Qual é a faixa de valores do atributo A em um conjunto S de casos de dados? |

- Qual é a gama de comprimentos de filme?

- Qual é a faixa de potência do carro? - Quais atrizes estão no conjunto de dados? |

| 7 | Caracterizar distribuição | Dado um conjunto de casos de dados e um atributo quantitativo de interesse, caracterize a distribuição dos valores desse atributo ao longo do conjunto. | Qual é a distribuição de valores do atributo A em um conjunto S de casos de dados? |

- Qual é a distribuição dos carboidratos nos cereais?

- Qual é a distribuição de idade dos compradores? |

| 8 | Encontre Anomalias | Identifique quaisquer anomalias dentro de um determinado conjunto de casos de dados com respeito a um determinado relacionamento ou expectativa, por exemplo, outliers estatísticos. | Quais casos de dados em um conjunto S de casos de dados têm valores inesperados / excepcionais? |

- Existem exceções para a relação entre potência e aceleração?

- Existem outliers na proteína? |

| 9 | Cacho | Dado um conjunto de casos de dados, encontre clusters de valores de atributos semelhantes. | Quais casos de dados em um conjunto S de casos de dados são semelhantes em valor para os atributos {X, Y, Z, ...}? |

- Existem grupos de cereais com gordura / calorias / açúcar semelhantes?

- Existe um aglomerado de durações de filme típicas? |

| 10 | Correlacionar | Dado um conjunto de casos de dados e dois atributos, determine relacionamentos úteis entre os valores desses atributos. | Qual é a correlação entre os atributos X e Y em um determinado conjunto S de casos de dados? |

- Existe correlação entre carboidratos e gordura?

- Existe correlação entre país de origem e MPG? - Os diferentes sexos têm um método de pagamento preferido? - Existe uma tendência de aumento da duração do filme ao longo dos anos? |

| 11 | Contextualização | Dado um conjunto de casos de dados, encontre a relevância contextual dos dados para os usuários. | Quais casos de dados em um conjunto S de casos de dados são relevantes para o contexto dos usuários atuais? | - Existem grupos de restaurantes que oferecem alimentos com base na minha ingestão calórica atual? |

Barreiras para uma análise eficaz

Podem existir barreiras para uma análise eficaz entre os analistas que realizam a análise de dados ou entre o público. Distinguir fato de opinião, preconceitos cognitivos e matemática são todos desafios para uma análise de dados sólida.

Fato e opinião confusos

Você tem direito à sua própria opinião, mas não tem direito aos seus próprios fatos.

Uma análise eficaz requer a obtenção de fatos relevantes para responder a perguntas, apoiar uma conclusão ou opinião formal ou testar hipóteses . Os fatos, por definição, são irrefutáveis, o que significa que qualquer pessoa envolvida na análise deve ser capaz de concordar com eles. Por exemplo, em agosto de 2010, o Congressional Budget Office (CBO) estimou que estender os cortes de impostos de Bush de 2001 e 2003 para o período de 2011-2020 acrescentaria aproximadamente US $ 3,3 trilhões à dívida nacional. Todos devem ser capazes de concordar que, de fato, isso é o que o CBO relatou; todos eles podem examinar o relatório. Isso torna isso um fato. Se as pessoas concordam ou discordam do CBO, é sua opinião.

Como outro exemplo, o auditor de uma empresa de capital aberto deve chegar a uma opinião formal sobre se as demonstrações financeiras das empresas de capital aberto são "apresentadas de forma justa, em todos os aspectos relevantes". Isso requer uma análise extensiva de dados factuais e evidências para apoiar sua opinião. Ao saltar dos fatos para as opiniões, sempre existe a possibilidade de que a opinião esteja errada .

Vieses cognitivos

Existem vários vieses cognitivos que podem afetar adversamente a análise. Por exemplo, o viés de confirmação é a tendência de buscar ou interpretar informações de uma forma que confirme os preconceitos de alguém. Além disso, os indivíduos podem desacreditar informações que não apóiem seus pontos de vista.

Os analistas podem ser treinados especificamente para estar cientes desses preconceitos e como superá-los. Em seu livro Psychology of Intelligence Analysis , o analista aposentado da CIA Richards Heuer escreveu que os analistas devem delinear claramente suas suposições e cadeias de inferência e especificar o grau e a fonte da incerteza envolvida nas conclusões. Ele enfatizou procedimentos para ajudar a expor e debater pontos de vista alternativos.

Inumeracia

Analistas eficazes geralmente são adeptos de uma variedade de técnicas numéricas. No entanto, o público pode não ter tal alfabetização com números ou numeramento ; eles são considerados inumeráveis. As pessoas que comunicam os dados também podem tentar enganar ou desinformar, usando deliberadamente técnicas numéricas inadequadas.

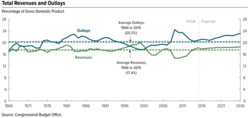

Por exemplo, se um número está aumentando ou diminuindo pode não ser o fator principal. Mais importante pode ser o número relativo a outro número, como o tamanho da receita ou gasto do governo em relação ao tamanho da economia (PIB) ou o valor do custo em relação à receita nas demonstrações financeiras corporativas. Essa técnica numérica é conhecida como normalização ou dimensionamento comum. Existem muitas dessas técnicas empregadas por analistas, seja ajustando para a inflação (ou seja, comparando dados reais vs. nominais) ou considerando aumentos populacionais, dados demográficos, etc. Os analistas aplicam uma variedade de técnicas para lidar com as várias mensagens quantitativas descritas na seção acima.

Os analistas também podem analisar dados sob diferentes hipóteses ou cenários. Por exemplo, quando os analistas realizam análises de demonstrações financeiras , eles frequentemente reformulam as demonstrações financeiras sob diferentes suposições para ajudar a chegar a uma estimativa do fluxo de caixa futuro, que eles então descontam a valor presente com base em alguma taxa de juros, para determinar a avaliação do empresa ou seu estoque. Da mesma forma, o CBO analisa os efeitos de várias opções de política sobre as receitas, despesas e déficits do governo, criando cenários futuros alternativos para medidas-chave.

Outros tópicos

Edifícios inteligentes

Uma abordagem de análise de dados pode ser usada para prever o consumo de energia em edifícios. As diferentes etapas do processo de análise de dados são realizadas a fim de realizar edifícios inteligentes, onde as operações de gerenciamento e controle do edifício, incluindo aquecimento, ventilação, ar condicionado, iluminação e segurança, são realizadas automaticamente, imitando as necessidades dos usuários do edifício e otimizando os recursos como energia e tempo.

Analytics e business intelligence

Analytics é o "uso extensivo de dados, análises estatísticas e quantitativas, modelos explicativos e preditivos e gerenciamento baseado em fatos para conduzir decisões e ações". É um subconjunto de business intelligence , que é um conjunto de tecnologias e processos que usa dados para entender e analisar o desempenho dos negócios para conduzir a tomada de decisões.

Educação

Na educação , a maioria dos educadores tem acesso a um sistema de dados com o objetivo de analisar os dados dos alunos. Esses sistemas de dados apresentam dados aos educadores em um formato de dados de venda livre (incorporando rótulos, documentação suplementar e um sistema de ajuda e tomando decisões de pacote / exibição e conteúdo chave) para melhorar a precisão das análises de dados dos educadores.

Notas do praticante

Esta seção contém explicações bastante técnicas que podem ajudar os profissionais, mas estão além do escopo típico de um artigo da Wikipedia.

Análise inicial de dados

A distinção mais importante entre a fase inicial de análise de dados e a fase de análise principal é que, durante a análise inicial de dados, a pessoa se abstém de qualquer análise que tenha como objetivo responder à questão original da pesquisa. A fase inicial de análise de dados é orientada pelas seguintes quatro questões:

Qualidade de dados

A qualidade dos dados deve ser verificada o mais cedo possível. A qualidade dos dados pode ser avaliada de várias maneiras, usando diferentes tipos de análise: contagens de frequência, estatística descritiva (média, desvio padrão, mediana), normalidade (assimetria, curtose, histogramas de frequência), imputação normal é necessária.

- Análise de observações extremas : as observações periféricas nos dados são analisadas para ver se parecem perturbar a distribuição.

- Comparação e correção de diferenças em esquemas de codificação: as variáveis são comparadas com esquemas de codificação de variáveis externas ao conjunto de dados e, possivelmente, corrigidas se os esquemas de codificação não forem comparáveis.

- Teste a variância do método comum .

A escolha das análises para avaliar a qualidade dos dados durante a fase inicial de análise de dados depende das análises que serão conduzidas na fase de análise principal.

Qualidade das medições

A qualidade dos instrumentos de medição só deve ser verificada durante a fase inicial de análise dos dados, quando este não for o foco ou questão de pesquisa do estudo. Deve-se verificar se a estrutura dos instrumentos de medição corresponde à estrutura relatada na literatura.

Existem duas maneiras de avaliar a qualidade da medição:

- Análise fatorial confirmatória

- Análise de homogeneidade ( consistência interna ), que dá uma indicação da confiabilidade de um instrumento de medição. Durante essa análise, são inspecionadas as variâncias dos itens e das escalas, o α de Cronbach das escalas e a mudança no alfa de Cronbach quando um item seria excluído de uma escala.

Transformações iniciais

Depois de avaliar a qualidade dos dados e das medições, pode-se decidir imputar dados perdidos ou realizar transformações iniciais de uma ou mais variáveis, embora isso também possa ser feito durante a fase de análise principal.

As possíveis transformações de variáveis são:

- Transformação de raiz quadrada (se a distribuição difere moderadamente do normal)

- Transformação de log (se a distribuição difere substancialmente do normal)

- Transformação inversa (se a distribuição for muito diferente do normal)

- Torne categórico (ordinal / dicotômico) (se a distribuição for muito diferente do normal e nenhuma transformação ajudar)

A implementação do estudo atendeu às intenções do projeto de pesquisa?

Deve-se verificar o sucesso do procedimento de randomização , por exemplo, verificando se as variáveis de fundo e substantivas estão igualmente distribuídas dentro e entre os grupos.

Caso o estudo não necessite ou utilize procedimento de randomização, deve-se verificar o sucesso da amostragem não aleatória, por exemplo, verificando se todos os subgrupos da população de interesse estão representados na amostra.

Outras possíveis distorções de dados que devem ser verificadas são:

- abandono (isso deve ser identificado durante a fase inicial de análise de dados)

- A não resposta do item (seja aleatória ou não deve ser avaliada durante a fase inicial de análise de dados)

- Qualidade do tratamento (usando verificações de manipulação ).

Características da amostra de dados

Em qualquer relatório ou artigo, a estrutura da amostra deve ser descrita com precisão. É especialmente importante determinar exatamente a estrutura da amostra (e especificamente o tamanho dos subgrupos) quando as análises de subgrupos serão realizadas durante a fase de análise principal.

As características da amostra de dados podem ser avaliadas observando:

- Estatísticas básicas de variáveis importantes

- Gráficos de dispersão

- Correlações e associações

- Tabulações cruzadas

Fase final da análise inicial dos dados

Durante o estágio final, os resultados da análise de dados inicial são documentados e as ações corretivas necessárias, preferíveis e possíveis são tomadas.

Além disso, o plano original para as análises de dados principais pode e deve ser especificado com mais detalhes ou reescrito.

Para fazer isso, várias decisões sobre as principais análises de dados podem e devem ser feitas:

- No caso de não normais : deve-se transformar as variáveis; tornar as variáveis categóricas (ordinais / dicotômicas); adaptar o método de análise?

- No caso de dados faltantes : deve-se negligenciar ou imputar os dados faltantes; qual técnica de imputação deve ser usada?

- No caso de outliers : deve-se usar técnicas de análise robustas?

- Caso os itens não se enquadrem na escala: deve-se adaptar o instrumento de medição omitindo itens, ou antes garantir a comparabilidade com outro (uso do) instrumento (s) de medição?

- No caso de subgrupos (muito) pequenos: deve-se abandonar a hipótese sobre diferenças entre grupos ou usar técnicas de pequenas amostras, como testes exatos ou bootstrapping ?

- Caso o procedimento de randomização pareça defeituoso: pode-se e deve-se calcular os escores de propensão e incluí-los como covariáveis nas análises principais?

Análise

Várias análises podem ser usadas durante a fase inicial de análise de dados:

- Estatísticas univariadas (variável única)

- Associações bivariadas (correlações)

- Técnicas gráficas (diagramas de dispersão)

É importante levar em consideração os níveis de medição das variáveis para as análises, pois técnicas estatísticas especiais estão disponíveis para cada nível:

- Variáveis nominais e ordinais

- Contagens de frequência (números e porcentagens)

- Associações

- circumambulações (tabulações cruzadas)

- análise log-linear hierárquica (restrita a um máximo de 8 variáveis)

- análise loglinear (para identificar variáveis relevantes / importantes e possíveis fatores de confusão)

- Testes exatos ou bootstrapping (no caso de os subgrupos serem pequenos)

- Cálculo de novas variáveis

- Variáveis contínuas

- Distribuição

- Estatísticas (M, SD, variância, assimetria, curtose)

- Expositores de caule e folha

- Plotagens de caixa

- Distribuição

Análise não linear

A análise não linear é freqüentemente necessária quando os dados são registrados a partir de um sistema não linear . Os sistemas não lineares podem exibir efeitos dinâmicos complexos, incluindo bifurcações , caos , harmônicos e sub - harmônicos que não podem ser analisados usando métodos lineares simples. A análise de dados não lineares está intimamente relacionada à identificação do sistema não linear .

Análise de dados principais

Na fase de análise principal, são realizadas análises destinadas a responder à questão de pesquisa, bem como qualquer outra análise relevante necessária para escrever o primeiro rascunho do relatório de pesquisa.

Abordagens exploratórias e confirmatórias

Na fase de análise principal, uma abordagem exploratória ou confirmatória pode ser adotada. Normalmente, a abordagem é decidida antes de os dados serem coletados. Em uma análise exploratória, nenhuma hipótese clara é declarada antes de analisar os dados, e os dados são pesquisados em busca de modelos que os descrevam bem. Em uma análise confirmatória, hipóteses claras sobre os dados são testadas.

A análise exploratória de dados deve ser interpretada com cuidado. Ao testar vários modelos ao mesmo tempo, há uma grande chance de descobrir que pelo menos um deles é significativo, mas isso pode ser devido a um erro do tipo 1 . É importante sempre ajustar o nível de significância ao testar vários modelos com, por exemplo, uma correção de Bonferroni . Além disso, não se deve seguir uma análise exploratória com uma análise confirmatória no mesmo conjunto de dados. Uma análise exploratória é usada para encontrar ideias para uma teoria, mas não para testar essa teoria também. Quando um modelo é encontrado exploratório em um conjunto de dados, o acompanhamento dessa análise com uma análise confirmatória no mesmo conjunto de dados pode simplesmente significar que os resultados da análise confirmatória são devidos ao mesmo erro tipo 1 que resultou no modelo exploratório no primeiro Lugar, colocar. A análise confirmatória, portanto, não será mais informativa do que a análise exploratória original.

Estabilidade de resultados

É importante obter algumas indicações sobre o quão generalizáveis são os resultados. Embora isso seja geralmente difícil de verificar, pode-se observar a estabilidade dos resultados. Os resultados são confiáveis e reproduzíveis? Existem duas maneiras principais de fazer isso.

- Validação cruzada . Ao dividir os dados em várias partes, podemos verificar se uma análise (como um modelo ajustado) com base em uma parte dos dados generaliza para outra parte dos dados também. A validação cruzada é geralmente inadequada, no entanto, se houver correlações dentro dos dados, por exemplo, com dados de painel . Conseqüentemente, outros métodos de validação às vezes precisam ser usados. Para mais informações sobre este tópico, consulte validação de modelo estatístico .

- Análise de sensibilidade . Um procedimento para estudar o comportamento de um sistema ou modelo quando os parâmetros globais são (sistematicamente) variados. Uma maneira de fazer isso é por meio de bootstrap .

Software grátis para análise de dados

Software livre notável para análise de dados inclui:

- DevInfo - Um sistema de banco de dados endossado pelo Grupo de Desenvolvimento das Nações Unidas para monitorar e analisar o desenvolvimento humano.

- ELKI - Framework de mineração de dados em Java com funções de visualização orientadas para mineração de dados.

- KNIME - The Konstanz Information Miner, uma estrutura de análise de dados abrangente e amigável.

- Laranja - uma ferramenta de programação visual com visualização de dados interativos e métodos para análise estatística de dados, mineração de dados e aprendizado de máquina .

- Pandas - biblioteca Python para análise de dados.

- PAW - Estrutura de análise de dados FORTRAN / C desenvolvida no CERN .

- R - Uma linguagem de programação e ambiente de software para computação estatística e gráficos.

- ROOT - framework de análise de dados C ++ desenvolvido no CERN .

- SciPy - biblioteca Python para análise de dados.

- Julia - uma linguagem de programação adequada para análise numérica e ciência computacional.

Concursos internacionais de análise de dados

Diferentes empresas ou organizações realizam concursos de análise de dados para incentivar os pesquisadores a utilizar seus dados ou para resolver uma questão específica usando a análise de dados. Alguns exemplos de concursos internacionais de análise de dados conhecidos são os seguintes:

- Competição Kaggle, que é realizada pela Kaggle .

- Concurso de análise de dados LTPP realizado pela FHWA e ASCE .

Veja também

- Ciência atuarial

- Analytics

- Big data

- Business Intelligence

- Censura (estatísticas)

- Física computacional

- Aquisição de dados

- Combinação de dados

- Gestão de dados

- Mineração de dados

- Arquitetura de apresentação de dados

- Ciência de dados

- Processamento de sinal digital

- Redução de dimensão

- Avaliação de caso inicial

- Análise exploratória de dados

- Análise de Fourier

- Aprendizado de máquina

- PCA Multilinear

- Aprendizagem subespaço multilinear

- Análise de dados multiway

- Pesquisa de vizinho mais próximo

- Identificação de sistema não linear

- Análise preditiva

- Análise do componente principal

- Pesquisa qualitativa

- Computação científica

- Análise de dados estruturados (estatísticas)

- Identificação do sistema

- Método de teste

- Analítica de texto

- Dados não estruturados

- Wavelet

- Lista de empresas de big data

Referências

Citações

Bibliografia

- Adèr, Herman J. (2008a). "Capítulo 14: Fases e etapas iniciais na análise de dados". Em Adèr, Herman J .; Mellenbergh, Gideon J .; Mão, David J (eds.). Aconselhamento sobre métodos de pesquisa: o companheiro de um consultor . Huizen, Holanda: Johannes van Kessel Pub. pp. 333–356. ISBN 9789079418015. OCLC 905799857 .

- Adèr, Herman J. (2008b). "Capítulo 15: A fase de análise principal". Em Adèr, Herman J .; Mellenbergh, Gideon J .; Mão, David J (eds.). Aconselhamento sobre métodos de pesquisa: o companheiro de um consultor . Huizen, Holanda: Johannes van Kessel Pub. pp. 357–386. ISBN 9789079418015. OCLC 905799857 .

- Tabachnick, BG & Fidell, LS (2007). Capítulo 4: Limpando seu ato. Dados de triagem antes da análise. Em BG Tabachnick & LS Fidell (Eds.), Using Multivariate Statistics, Fifth Edition (pp. 60-116). Boston: Pearson Education, Inc. / Allyn and Bacon.

Leitura adicional

- Adèr, HJ & Mellenbergh, GJ (com contribuições de DJ Hand) (2008). Aconselhamento sobre métodos de pesquisa: um companheiro do consultor . Huizen, Holanda: Johannes van Kessel Publishing. ISBN 978-90-79418-01-5

- Chambers, John M .; Cleveland, William S .; Kleiner, Beat; Tukey, Paul A. (1983). Graphical Methods for Data Analysis , Wadsworth / Duxbury Press. ISBN 0-534-98052-X

- Fandango, Armando (2017). Análise de dados Python, 2ª edição . Packt Publishers. ISBN 978-1787127487

- Juran, Joseph M .; Godfrey, A. Blanton (1999). Manual de qualidade de Juran, 5ª edição. Nova York: McGraw Hill. ISBN 0-07-034003-X

- Lewis-Beck, Michael S. (1995). Análise de dados: uma introdução , Sage Publications Inc, ISBN 0-8039-5772-6

- NIST / SEMATECH (2008) Manual de Métodos Estatísticos ,

- Pyzdek, T, (2003). Quality Engineering Handbook , ISBN 0-8247-4614-7

- Richard Veryard (1984). Análise de dados pragmática . Oxford: Blackwell Scientific Publications. ISBN 0-632-01311-7

- Tabachnick, BG; Fidell, LS (2007). Usando Estatísticas Multivariadas, 5ª Edição . Boston: Pearson Education, Inc. / Allyn and Bacon, ISBN 978-0-205-45938-4